ในเวลาเพียงไม่กี่ปี ภูมิทัศน์ของปัญญาประดิษฐ์ (AI) ได้เปลี่ยนแปลงจากเครื่องมือทดลองในห้องแล็บ กลายเป็นโครงสร้างพื้นฐานสำคัญที่ขับเคลื่อนเศรษฐกิจและชีวิตประจำวัน กติกาการแข่งขันกำลังถูกเขียนขึ้นใหม่ทั้งหมด จากยุคที่เน้นการ “เพิ่มขนาดโมเดล” (Scaling) กำลังถูกท้าทายด้วย “การให้เหตุผลเชิงลึก” (Reasoning) และคำถามสำคัญเรื่อง “ความรับผิดชอบ” (Responsibility) ก็ดังขึ้นกว่าที่เคย

รายงาน SCBX AI Outlook 2025 Volume 2 ได้ฉายภาพ 4 จุดเปลี่ยนสำคัญ (ACTs) ที่กำลังกำหนดอนาคตของ AI โดยชี้ให้เห็นว่าสนามรบต่อไปไม่ได้วัดกันที่ว่าใครมีโมเดลที่ “ใหญ่” ที่สุด แต่ใครสามารถสร้าง AI ที่ “ฉลาด” ที่สุด “รับผิดชอบ” ที่สุด และ “เข้าใจโลกความจริง” (Reality) ได้มากที่สุด

นี่คือบทวิเคราะห์ 4 เทรนด์สำคัญที่องค์กรและนักพัฒนาต้องจับตามอง

Closing the Gap – เมื่อ “โมเดลเปิด” ไล่บี้ “ยักษ์ใหญ่”

สมรภูมิ AI ที่เคยถูกผูกขาดโดยโมเดลปิด (Closed Source) ของบริษัทยักษ์ใหญ่ กำลังสั่นสะเทือนอย่างรุนแรง การแข่งขันที่ดุเดือดจากชุมชนโอเพนซอร์ส (Open Source) กำลัง “ลดช่องว่าง” (Closing the Gap) เข้ามาอย่างรวดเร็ว

รายงาน AI Index 2025 จาก Stanford HAI ชี้ว่า แม้โมเดลส่วนใหญ่จะมาจากภาคอุตสาหกรรม แต่ช่องว่างด้านประสิทธิภาพระหว่างโมเดลเปิดและปิดลดลงจาก 8% เหลือเพียง 1.7% ในบางเบนซ์มาร์ก ภายในเวลาเพียงหนึ่งปี โมเดลเปิดอย่าง DeepSeek V3.1 ที่มาพร้อมสถาปัตยกรรมไฮบริด สลับโหมด “Think” (คิดลึก) และ “Non-Think” (ตอบเร็ว) หรือ Qwen จากจีน ต่างก็กำลังท้าชนโมเดลปิดอย่าง GPT ในการทดสอบ MMLU (Massive Multitask Language Understanding)

ความเคลื่อนไหวที่น่าสนใจคือ แม้แต่ผู้นำตลาดอย่าง OpenAI ก็ยังต้องปรับตัว โดยการเปิดตัว GPT-5 ที่มีสถาปัตยกรรม Unified System เลือกเราเตอร์อัจฉริยะระหว่างโมเดลเร็วและโมเดลคิดลึกอัตโนมัติ แต่ในขณะเดียวกัน ก็สร้างแรงสั่นสะเทือนด้วยการปล่อยโมเดลโอเพนซอร์สของตัวเองเป็นครั้งแรก (gpt-oss-120b และ gpt-oss-20b) นี่คือสัญญาณชัดเจนว่าพลังของโอเพนซอร์สคือของจริงที่แม้แต่ยักษ์ใหญ่ก็ไม่อาจเมินได้

สมรภูมิจริงคือ “Ecosystem” และ “Cost”

การแข่งขันนี้ส่งผลโดยตรงต่อ “ราคา” ที่ลดลงอย่างมหาศาล แต่สงครามที่แท้จริงกลับย้ายไปอยู่ที่ว่า “ใครจะสร้างระบบนิเวศ (Ecosystem) ได้ดีกว่ากัน”

- Google ใช้จุดแข็งจากการฝัง Gemini เข้าไปในบริการที่คนใช้ทุกวัน (Search, Gmail, Android) และผลักดันโครงสร้างเปิดอย่าง Agent Development Kit (ADK)

- Microsoft + OpenAI เน้นการฝังสมอง AI (Copilot) ลงในเครื่องมือองค์กร (Office, Teams, GitHub) โดยการันตีความปลอดภัยผ่าน Azure

สำหรับบริบทประเทศไทย แนวคิดโมเดลเปิดกำลังขับเคลื่อนการพัฒนา AI อย่างแข็งแกร่ง ตัวอย่างชัดเจนคือ “Typhoon” จาก SCB10X ที่เปิดให้ใช้งานฟรี ถูกฝึกมาเพื่อบริบทภาษาไทยโดยเฉพาะ ด้วยยอดดาวน์โหลดกว่า 2.6 ล้านครั้ง และการเรียกใช้ API มากกว่า 30 ล้านครั้ง สะท้อนให้เห็นว่าตลาดไทยต้องการโซลูชันที่ยืดหยุ่น ปรับแต่ง (Fine-tune) ได้ และมีต้นทุนที่เหมาะสม

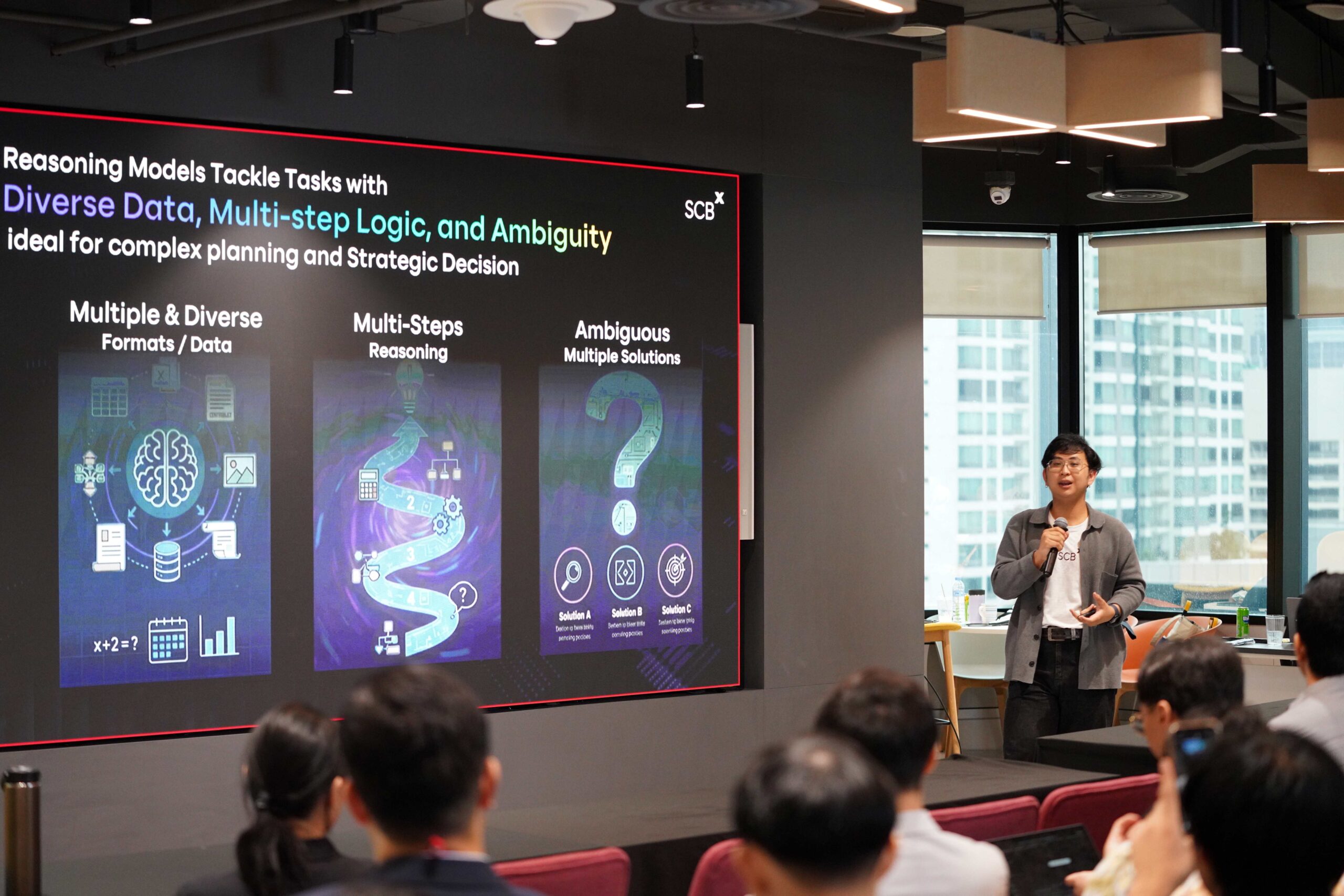

Beyond Scaling – ยุค “อัดพารามิเตอร์” ถึงทางตัน

กฎการขยายโมเดล (Scaling Laws) ที่ว่า “ยิ่งใหญ่ยิ่งเก่ง” กำลังเผชิญกับภาวะผลตอบแทนลดน้อยถอยลง (Diminishing Returns) จุดเปลี่ยนใหม่คือการพัฒนา “การให้เหตุผลที่ฉลาดขึ้น” (Smarter Paths of Reasoning)

แนวทางใหม่ที่เรียกว่า “Test-Time Scaling” หรือการให้โมเดล “คิดนานขึ้นก่อนตอบ” (เช่น ตระกูล O-series ของ OpenAI) ช่วยให้ผลลัพธ์แม่นยำขึ้น แต่มันก็นำไปสู่ปัญหา “Overthinking” คือการคิดมากเกินไปจนประสิทธิภาพลดลง โดยเฉพาะในโมเดลขนาดเล็ก

กุญแจสำคัญจึงไม่ใช่การคิด “นานขึ้น” แต่คือการคิด “อย่างมีกลยุทธ์” โดยใช้เทคนิคการเรียนรู้แบบเสริมกำลัง (Reinforcement Learning – RL) เข้ามาช่วยให้โมเดลเรียนรู้กลยุทธ์ที่ดีที่สุดด้วยตัวเอง

“Accuracy per Token” คือมาตรวัดใหม่ของโลกธุรกิจ

เมื่อโมเดลคิดได้ลึกขึ้น คำถามที่ภาคธุรกิจต้องตอบคือ “ความแม่นยำที่เพิ่มขึ้น คุ้มกับต้นทุนการประมวลผลที่สูงขึ้นหรือไม่?” นี่คือที่มาของตัวชี้วัดใหม่ “ความแม่นยำต่อจำนวนโทเค็น” (Accuracy per Token)

โมเดลที่ตลาดต้องการในอนาคตคือโมเดลที่ “คิดได้คุ้ม” คือ ฉลาด กระชับ แม่นยำ และใช้โทเคนน้อยที่สุดภายใต้งบประมาณจำกัด

ก้าวต่อไป: ระบบที่พัฒนาตัวเองได้ (Self-Improving Systems)

เทรนด์นี้กำลังนำไปสู่ระบบ AI ที่สามารถเรียนรู้และปรับปรุงตัวเองได้ เช่น AlphaEvolve ของ Google DeepMind ที่เป็น AI Agent เขียนโค้ดเชิงวิวัฒนาการเพื่อเพิ่มประสิทธิภาพให้ชิป TPU ของ Google หรือในไทยอย่าง SCBX PromptEvolve ที่ใช้ Evolution Algorithm เพื่อปรับปรุงคุณภาพ Prompt โดยอัตโนมัติ

ในกรณีศึกษาจริง SCBX PromptEvolve สามารถเพิ่มความแม่นยำของการประเมินบทสนทนาทางธุรกิจจาก 79% เป็น 96% โดยอัตโนมัติ นี่คือยุคที่ AI กำลังวิวัฒน์จาก “เครื่องมือ” ไปสู่ “สิ่งสร้างปัญญา” ที่เรียนรู้และเติบโตได้เอง

With Great AI Power Comes Great AI Responsibility

ยิ่ง AI ทรงพลัง คำถามเรื่อง “ความรับผิดชอบ” ก็ยิ่งใหญ่ขึ้น ความกังวลนี้ไม่ได้มาจากแค่ผู้ใช้งาน แต่มาจาก “บิดาแห่ง AI” (Godfathers of AI) อย่าง Yoshua Bengio, Geoffrey Hinton และ Demis Hassabis ที่ต่างออกมาเตือนถึงความเสี่ยง

“Responsible AI” ไม่ใช่ทางเลือกอีกต่อไป แต่เป็น “เงื่อนไขที่ทุกองค์กรต้องมี” ด้วย 4 เหตุผลหลัก

- กฎระเบียบโลก (Global Regulations): กฎหมายอย่าง EU AI Act หรือมาตรฐาน NIST RMF ของสหรัฐฯ กำลังบีบให้องค์กรต้องปฏิบัติตาม

- การตื่นตัวของนักวิจัย: เกิดสตาร์ตอัปที่เน้นความปลอดภัยโดยเฉพาะ เช่น LawZero ของ Yoshua Bengio และ Safe Superintelligence Inc (SSI) ของ Ilya Sutskever (อดีต OpenAI)

- การลดความเสี่ยง (Risk Mitigation): ความผิดพลาดของ AI ในยุคนี้แพร่กระจายเร็วและสร้างความเสียหายต่อชื่อเสียงอย่างรุนแรง

- ความได้เปรียบทางการแข่งขัน (Competitive Advantage): ความไว้วางใจ (Trust) คือสกุลเงินใหม่ในยุคดิจิทัล

หลักการสำคัญที่องค์กรต้องยึดถือ

รายงานได้เน้นย้ำถึงบทเรียนราคาแพงในอดีต

- Fairness and Bias Mitigation: ต้องป้องกันอคติ กรณีศึกษา Apple Card ที่ถูกสอบสวนว่าให้วงเงินเครดิตต่างกันระหว่างเพศ ชี้ว่าแม้ผลลัพธ์จะเกิดจากปัจจัยทางกฎหมาย แต่การขาดความโปร่งใสก็ทำลายความไว้วางใจได้

- Accountability and Governance: ต้องมีผู้รับผิดชอบที่ชัดเจน บทเรียนจาก Microsoft Tay แชทบอทที่เรียนรู้คำเหยียดเชื้อชาติจากผู้ใช้ จนต้องปิดตัวใน 24 ชั่วโมง คือฝันร้ายด้าน PR ที่เกิดจากการขาดการกำกับดูแล

- Transparency and Explainability: ต้องอธิบายได้ว่าทำไม AI ตัดสินใจแบบนั้น เพื่อหลีกเลี่ยงสภาวะ “Blackbox”

อนาคตของ AI ไม่ได้วัดกันที่ความฉลาดเพียงอย่างเดียว แต่วัดที่ว่ามันทำให้โลกดีขึ้นหรือไม่

The Reality Engine – สอน AI ให้ “เข้าใจโลกจริง”

ความสำเร็จของ LLMs คือการที่มัน “เข้าใจภาษา” แต่ข้อจำกัดใหญ่คือมันไม่ “เข้าใจโลกกายภาพ” มันไม่รู้ว่าถ้าผลักแก้วน้ำ แก้วจะตกลงมาอย่างไร

ก้าวต่อไปที่สำคัญคือ “World Models” นี่คือระบบ AI ที่ถูกสร้างมาเพื่อจำลองและเข้าใจว่าโลกทำงานอย่างไร ผ่านกฎฟิสิกส์ ความสัมพันธ์เชิงเหตุและผล ความแตกต่างคือ LLM เรียนรู้จาก “ข้อความ” (Text) แต่ World Model เรียนรู้จาก “ข้อมูลประสาทสัมผัสหลากหลายรูปแบบ” (Multi-modal sensory data) และ “การโต้ตอบ” กับสิ่งแวดล้อมจริงหรือจำลอง

การกลับมาของ “Godmother of AI”

Fei-Fei Li ผู้อยู่เบื้องหลัง ImageNet ที่ปฏิวัติวงการ Computer Vision กำลังกลับมาปฏิวัติวงการอีกครั้งด้วย “WorldLabs” ภารกิจของเธอคือการสร้าง Large World Models (LWMs) เพราะเธอเชื่อว่า “AGI จะไม่สมบูรณ์หากขาดความฉลาดเชิงพื้นที่ (Spatial Intelligence)”

LWMs ของ WorldLabs จะมีความสามารถ 4 ด้าน

- สร้างสภาพแวดล้อม 3 มิติ จากข้อมูลง่าย ๆ (เช่น ภาพ 2 มิติ)

- “See and Do” (เห็นและทำ) ไม่ใช่แค่ “See and Talk” (เห็นและพูด) คือรู้ว่าประตูเปิดได้ เก้าอี้นั่งได้

- ทำนายสิ่งที่จะเกิดขึ้น (เช่น คำนวณวิถีลูกบอล)

- วางแผนการกระทำ โดยการ “ซ้อมในใจ” (จำลองสถานการณ์ในหัว) ก่อนทำจริง

เข้าสู่ “Era of Experience”

เรากำลังเปลี่ยนจากยุค “Era of Human Data” (ที่ AI เรียนรู้จากข้อมูลมนุษย์ป้อนให้) ไปสู่ “Era of Experience” คือยุคที่ AI จะเรียนรู้จาก “ประสบการณ์ของตัวเอง” ไม่ต่างจากเด็กที่เรียนรู้จากการลองผิดลองถูก โดยมี Reinforcement Learning เป็นหัวใจสำคัญ

สำหรับภาคการเงิน นี่คือ Game Changer ที่แท้จริง เช่น

- Generative Market Simulation: สร้างแบบจำลองตลาดที่สมจริง เพื่อทดสอบกลยุทธ์การลงทุนกับสถานการณ์ที่ไม่เคยเกิดขึ้นในอดีต (Blackswan)

- Enhanced Fraud Detection: จำลองเครือข่ายทางการเงินและพฤติกรรมมิจฉาชีพรูปแบบใหม่ ๆ เพื่อสร้างการป้องกันล่วงหน้า

Thumbsup มองว่า รายงาน SCBX AI Outlook 2025 ชี้ชัดว่า AI กำลังเคลื่อนตัวจาก “พลังดิบ” ไปสู่ “ความเฉลียวฉลาดที่ซับซ้อน” การแข่งขันที่แท้จริงได้ย้ายจาก “ขนาด” ไปสู่ “ประสิทธิภาพต่อต้นทุน” (Accuracy per Token) และจาก “ความสามารถ” ไปสู่ “ความรับผิดชอบ” และ “ความเข้าใจโลก” นี่คือการเปลี่ยนแปลงเชิงกระบวนทัศน์ที่ทุกองค์กรต้องเตรียมพร้อมรับมือ

อ่านเพิ่มเติม